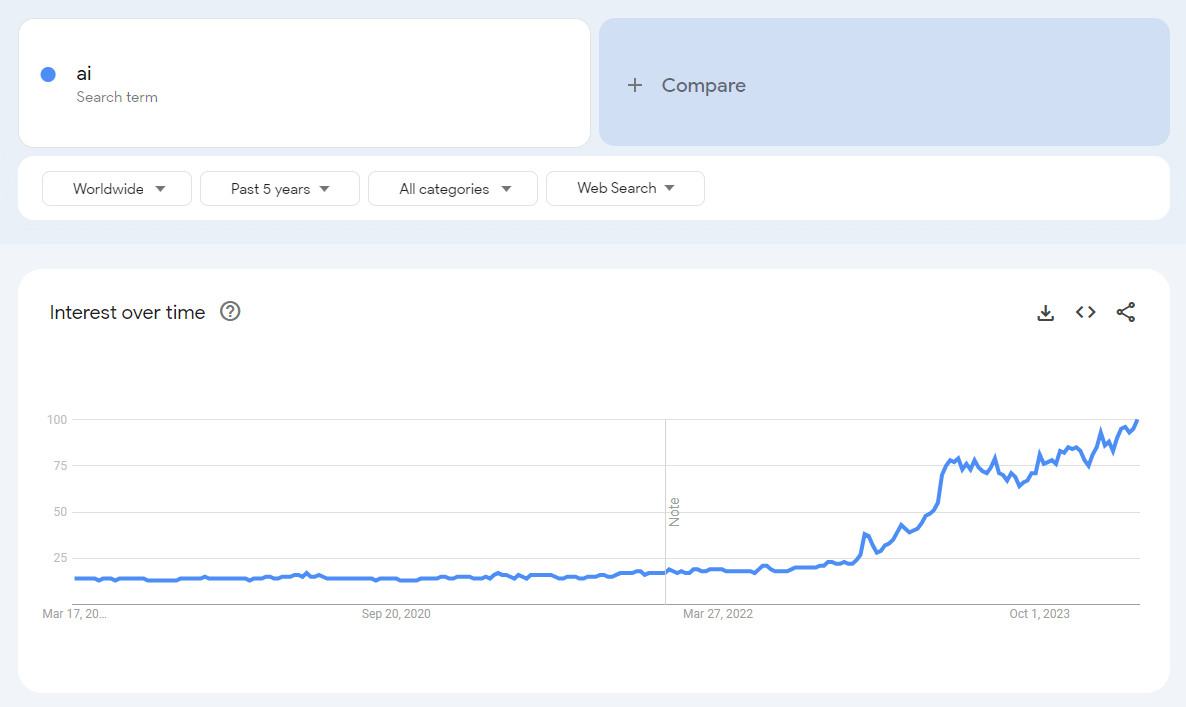

L’era dell’intelligenza artificiale (AI) è iniziata molto tempo fa. Le persone si sono abituate all'identificazione e alla registrazione immediate, alla ricerca più rapida di trasporti e percorsi, alla comoda selezione dei beni e all'uso dei servizi di intelligenza artificiale. L’intelligenza artificiale è diventata un assistente affidabile per le imprese, ha sostituito i dipendenti e ha ridotto a zero la probabilità di errori dovuti al fattore umano. Il lavoro di routine è stato relegato alla categoria del lavoro affidato all’intelligenza artificiale, mentre le attività creative sono gestite da specialisti leader.

Applicazioni e reti neurali, algoritmi di azione dell'IA

Modelli e algoritmi, applicazioni e chatbot basati sull'intelligenza artificiale vengono sviluppati da ciascuna delle società IT utilizzando l'apprendimento automatico e il deep learning per analizzare i dati digitali. Per i progetti impegnativi vengono collegate le reti neurali negli affari. La visualizzazione con l'intelligenza artificiale è il riconoscimento e la visione artificiale 3D.Programmi bancari, siti di scommesse sportive si basano spesso sul lavoro di un assistente AI intelligente. Operazioni eseguite dall'IA secondo criteri specificati su scambi, acquisti, vendite - vita quotidiana. Anche la preselezione del personale in base a indicatori specifici, la diagnosi iniziale dei pazienti, l’impostazione di azioni di sicurezza quando viene attivato un determinato trigger sono il risultato del pensiero dell’IA. Si vocifera da diversi anni sulla generazione di contenuti di testo, immagini e video di medio livello.

L'analisi delle immagini del quadricottero FPV è un modo conveniente per valutare il terreno in tempo reale. Può essere configurato per essere inviato direttamente a un data center per un processo decisionale accelerato assistito dall'intelligenza artificiale in situazioni di base. L’automazione dei processi è uno degli altri vantaggi dell’implementazione dell’intelligenza artificiale.

Riconoscimento e verifica, diagnosi e prognosi con l'AI

Esempi di come l’intelligenza artificiale può essere utilizzata nelle operazioni commerciali delle agenzie di viaggio includono il riconoscimento di passaporti, assicurazioni e documenti dei viaggiatori. È facile inserire questi dati nei moduli di domanda o nei contratti con tassi di errore minimi, fino all'1-5%. Il riconoscimento della rete neurale viene addestrato analizzando foto e testo nello spazio, con adattamento e verifica, formando una risposta API. Il software stesso, realizzato utilizzando tecnologie RPA, è integrabile in qualsiasi sistema CRM o chatbot, dashboard utente.Il robot RPA sta completando la documentazione di routine, generando report ed eseguendo operazioni per impostare l'orario di lavoro. La formazione viene eseguita con l'aiuto dell'apprendimento automatico ML. La creazione e l'addestramento di reti neurali, sia convoluzionali che generative in architettura, è una delle tecniche ML utilizzate di frequente. Le reti neurali hanno la capacità di prevedere il commercio di criptovalute e i prezzi, diagnosticare malattie o compromissione funzionale. Gli scienziati li utilizzano per fare previsioni sulle caratteristiche di qualità dei farmaci basati sui componenti e per valutare le condizioni di un oggetto o di una lega pianificati.

Modellazione delle decisioni con la scienza dei dati

Costruire database e mostrarli all’intelligenza artificiale non basta: bisogna insegnarle a riconoscere le situazioni in cui è necessario dare una risposta chiara in tempi rapidi. Queste sono situazioni in cui i database relazionali non riescono a trovare la giusta soluzione. Tali questioni sono affrontate dagli analisti di Data Science. Sono responsabili della determinazione degli algoritmi e delle condizioni del modello matematico in cui viene implementato:- modellazione dei processi;

- segmentazione e personalizzazione dei clienti, richieste chiave;

- pertinenza delle offerte.

Per visualizzare il processo, supponiamo che una persona stia guidando un'auto. Ha ricevuto una telefonata che ha provocato un'ondata di endorfine. Di conseguenza, il suo battito cardiaco è aumentato, ma la sua capacità di attenzione è diminuita e c'era il desiderio di "guidare veloce". Il tracker sul tuo braccio lo rileva e trasmette le informazioni al sistema AI dell'auto. L'intelligenza artificiale emette un avviso: consiglia di ridurre la velocità (o lo fa da sola), riduce il calore nell'abitacolo e apre il finestrino.

Una sfida per l'IA

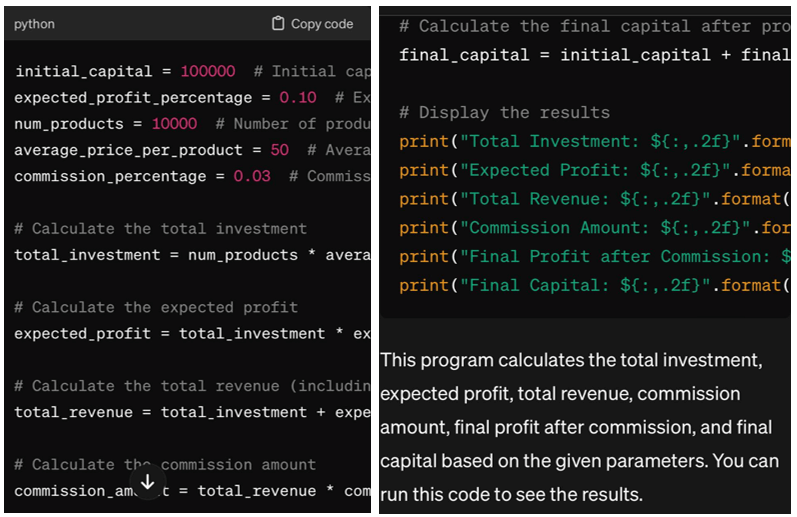

L’intelligenza artificiale non è semplicemente il pensiero umano. I computer eseguono ciò che il programmatore richiede loro: calcolare, calcolare, eseguire azioni specifiche. Puoi impostare l'attività tramite voce o testo, ma prima introduci regole e vincoli, dipendenze, comprese quelle statistiche. Gli algoritmi di trasformazione sono schemi modello per modello: "Descrizione" - "Regole" o "Attività" - "Soluzioni". La previsione funziona se vengono introdotte diverse situazioni con esempi.Considera il seguente compito: "Scrivi un programma in Python per generare profitti sul mercato. Capitale iniziale 100 mila dollari, profitto atteso 10% dell'investimento, numero di beni sul mercato 10000, prezzo medio di un prodotto 50 dollari, commissione di 3 %".

Il risultato sarà la risposta sopra menzionata, che è limitata a causa dell'introduzione di un numero limitato di indicatori nelle condizioni problematiche. Quanto più dettagliati sono i fattori e maggiore è la dimensione del set di dati, tanto minore è l’errore nella soluzione finale. Durante l'addestramento dell'IA, il programmatore inserisce le informazioni iniziali e tagga ciascun frammento. Una volta accumulato il database con i marcatori di controllo, l'addestramento passa alla fase di ricerca e verifica delle regole nella previsione.

Scenari ed errori di modellazione dei passaggi

Ogni fase consiste nel trovare uno schema prescritto e cercarne uno nuovo con un determinato parametro. Ad esempio, se è arrivata un'auto Mersedes, poi Audi e Honda, la prossima potrebbe essere BMW o Mitsubishi. Se non è necessario cercare modelli, disabilitiamo questa funzione e utilizziamo le soluzioni dei passaggi precedenti.Uno scenario in cui il primo indicatore è seguito da una domanda e il successivo indicatore è seguito da una risposta rende conveniente l'algoritmo, poiché risponderà a qualsiasi domanda entro i limiti della base di informazioni. È chiaro che c’è un errore in ogni algoritmo di previsione.

È accettabile se i margini di errore rientrano nel 5%. Il modello stocastico è adatto quando non vi è certezza nell'intervallo di input dei dati di input o di output. Una funzione locale con mappatura a valore singolo è guidata da identificatori di oggetto. Le funzioni semplici sono a un parametro, i calcoli in esse vengono eseguiti tramite coefficienti, ma non tramite dichiarazioni, è falso o vero. Si tratta di un modello abbastanza semplice, ma può essere potentemente utilizzato nello sviluppo dei marketplace. Ad esempio, per analizzare il comportamento dell'utente e offrire prodotti migliori specifici per lui.

Algoritmi, risultati e funzioni di analisi

Ogni algoritmo è suddiviso in passaggi: condizioni e transizioni, ognuno dei quali termina con un operatore risultato, ma non con un ritorno. Il confronto con una costante, che rappresenta un certo punto o passo dell'algoritmo, è la base per la previsione continua. Può essere paragonato alla ricerca di correlazione, quando i dati delle caratteristiche correlate vengono accumulati e combinati in gruppi. Quindi, in base al risultato della base ottenuta, vengono selezionate le condizioni generali e la distanza tra il parametro indicato e il risultato del calcolo.Sembra questo:

- formare funzioni con un parametro;

- selezione di parti con le stesse condizioni;

- creazione di una nuova funzione a due parametri;

- affinamento della linearità in basi multiparametriche.

La conversione implica algoritmi per trovare soluzioni e quindi creare regole basate sulle risposte. A volte il risultato è una ricorsione a più livelli o un frattale. I token di controllo rispondono alle query e producono calcoli finali, tenendo conto della velocità, dell'accelerazione e dell'errore del processo. Tuttavia, gli algoritmi si basano su statistiche.

Fiducia in se stessi e autonomia: bilanciare analisi e decisioni

È insolito che un computer cerchi una soluzione o conduca una ricerca senza un compito. Anche se programmato condizionatamente come personalità umana, senza un compito il PC non eseguirà azioni specifiche. La logica formale qui non funziona, abbiamo bisogno di matematica e statistica. Le decisioni prese dall'intelligenza artificiale in modo autonomo devono essere analizzate: se vanno oltre i confini di algoritmi e script, ma rappresentano un'opzione preferibile, allora questa è la conferma della correttezza della decisione sull'"autonomia".Principi dell’intelligenza artificiale:

- l'analisi predittiva con l'individuazione di modelli e tendenze viene applicata alle previsioni basate su modelli e probabilità di eventi;

- la multimodalità implica l'elaborazione simultanea di informazioni provenienti da diverse fonti e tipologie di dati;

- il metodo multidisciplinare assomiglia al metodo scientifico, poiché va all'intersezione di diverse scienze e dei loro rami al fine di migliorare le prestazioni dell'IA.

Il livello massimo di analisi è presso l'ASI, che assomiglia al pensiero umano. L'intelligenza dell'AGI è vicina al livello medio del pensiero umano. ANI è un tipico interprete che non va oltre i compiti del programma scritto.

Formazione con numeri, riconoscimenti e con informazioni incomplete

L’accumulo di enormi quantità di dati richiede una formazione sull’intelligenza artificiale. Per il formato macchina vengono utilizzati la regressione lineare e multivariata, i vettori di supporto, l'albero decisionale con sottocategorie e i vicini KNN. L'apprendimento per rinforzo include algoritmi per robot. La comunicazione tramite chatbot è il risultato dell'utilizzo di Transformers dopo l'elaborazione del linguaggio umano.Il compito della PNL è il riconoscimento di testo e audio, la traduzione e la generazione di contenuti. 6 anni fa, i programmatori di Facebook hanno sviluppato un bot basato sui dati di Amazon (6mila dialoghi reali) che non era diverso da un essere umano, poteva contrattare e persino imbrogliare. Ciò dimostra che i compiti dell’intelligenza artificiale negli schemi di marketing e di intrattenimento sono diversi:

- nel commercio al dettaglio, pensano attraverso algoritmi per elaborare promozioni e offerte di acquisto;

- nella ristorazione realizzano interni e menù originali;

- nel settore dei giochi, dopo una formazione approfondita, sviluppano una mente ideale composta da un manager AI e programmi di agenti con "architettura ibrida".

Guardando l'esempio del programma Libratus, diventa chiaro che l'intelligenza artificiale è composta da più parti. La parte centrale analitica interagisce con la seconda parte, che tiene traccia degli errori degli avversari, e la terza parte, che analizza gli errori nelle proprie azioni. Questo è un esempio di utilizzo di informazioni incomplete per fornire una risposta completa ed esauriente nel settore della sicurezza informatica, in ambito militare e nelle negoziazioni, anche in progetti come siti di incontri dove il matchmaking viene effettuato con l'aiuto dell'analisi.

Modelli con soluzioni corrette e funzionamento ChatGPT-3.5

Dodici anni fa gli economisti Shepley e Roth ricevettero il Premio Nobel per la teoria della distribuzione stabile. Le soluzioni dei matematici hanno trovato conferma nell'informatica: le tecniche di distribuzione unimodale e bimodale funzionano se si recluta un database multimiliardario e poi lo si analizza sotto forma di istogrammi. Gli sviluppatori nei laboratori di OpenAI e Google, Microsoft monitorano costantemente la formazione dell'IA, eliminando soluzioni errate e creando modelli basati su quelli corretti. Sono 60mila le aziende IT registrate nel mondo per lo sviluppo di software basato sull’intelligenza artificiale.

La versione 3 di ChatGPT utilizzava solo 175 miliardi di fonti. La versione 5, che sarà rilasciata entro la fine del 2024, genererà contemporaneamente contenuti testuali e audiovisivi. Il numero di fonti per lo sviluppo è 100 volte la quantità di dati di ChatGPT-3. La versione avanzata e potente analizzerà i dati, funzionerà come base per i chatbot, genererà codice ed eseguirà altre funzioni di assistente virtuale. Finora, il modello 3.5 funziona in questo modo ed è soggetto a errori.

Prodotti IA di Google e Microsoft

Le comprovate applicazioni di intelligenza artificiale includono DALL-E, che genera e modifica immagini e crea collage. Whisper: un trascrittore AI universale in grado di riconoscere il parlato e tradurre. CLIP - un analogizzatore di immagini e foto. Gym Library and Codex: piattaforme basate sull'intelligenza artificiale per programmatori. L'elenco di Google ha 15 applicazioni e piattaforme AI simili. È vero, ci sono spesso bug ed errori nel loro lavoro.Gli algoritmi AI vengono utilizzati in Google Foto e Youtube, un traduttore per migliorare le funzionalità e analizzare i dati. Il chatbot di Google Bard è analogo a ChatGPT, ma con il proprio linguaggio PaLM 2. Questo può essere utilizzato contemporaneamente a Gemini, che ha un alto livello di generazione e analisi. Imagen AI genera immagini, Generative AI è un tester di modelli di apprendimento generativo. Vertex AI aiuta gli scienziati a elaborare i dati, Dialogflow serve per creare chatbot.

Le piattaforme AI di Microsoft includono l'enciclopedia universale Copilot, il servizio per sviluppatori di Azure Space che genera immagini, immagini e loghi, schizzi di Image Creator.

La Gran Bretagna e Foxconn di Taiwan sfrutteranno l'intelligenza artificiale

Nel catasto HMLR del Regno Unito, dove vengono registrati i titoli fondiari e di proprietà, metà del lavoro viene svolto dall'AI. Il monitoraggio delle prestazioni del software e delle applicazioni viene eseguito da APM, quindi Atlassian utilizza strumenti della piattaforma basati sull'intelligenza artificiale per monitorare i processi e assicurarsi che non vi siano errori. Questo è il motivo per cui l’intelligenza artificiale viene spesso utilizzata per la manutenzione preventiva di sistemi vitali, valutando le condizioni tecniche per prevenire tempi di fermo e incidenti.La previsione aziendale di un progetto o di un'operazione aziendale specifica migliora la precisione e consente di risparmiare sul budget. Foxconn, ad esempio, produttore taiwanese di componenti per smartphone e prodotti Apple, risparmia più di mezzo milione di dollari in una fabbrica messicana grazie allo sviluppo dell'intelligenza artificiale basata su Amazon Forecast.

Deep learning e scuole per l'intelligenza artificiale

Programmatori e sviluppatori stanno addestrando neuroni artificiali (nodi) a risolvere problemi utilizzando metodi di deep learning. Ciò include un algoritmo NLP per l’elaborazione del linguaggio, del significato e del tono e un’intelligenza artificiale generativa i cui contenuti e artefatti audio, video e testuali sono simili a quelli umani. I dati grezzi - risorse con sottolivelli - rappresentano l'infrastruttura operativa su cui avviene l'apprendimento. Possono essere archiviati su risorse fisiche o nel cloud.Una sorta di "scuole" per l'intelligenza artificiale: piattaforme come TensorFlow o PyTorch. È disponibile una libreria open source Scikit-learn scritta in Python. Per la formazione si formano funzioni e si realizzano classi secondo il piano dell'architettura dell'applicazione AI. A livello di modellazione viene determinata la potenza, quindi la segmentazione per livelli e la funzionalità di attivazione.

Gli sviluppatori analizzano come i neuroni cambiano il peso dei loro vicini durante la comunicazione e stimano lo spostamento dei nodi. La previsione e i dati reali non dovrebbero essere troppo diversi tra loro: a questo scopo viene utilizzato il confronto utilizzando una funzione di perdita. In questo processo, aiutano gli ottimizzatori come la discesa del gradiente o le sequenze del gradiente adattativo, che tengono conto dei minimi e dei massimi e della rapidità del cambiamento. L'intelligenza artificiale nel formato dell'applicazione è al servizio del cliente anziché del dipendente.

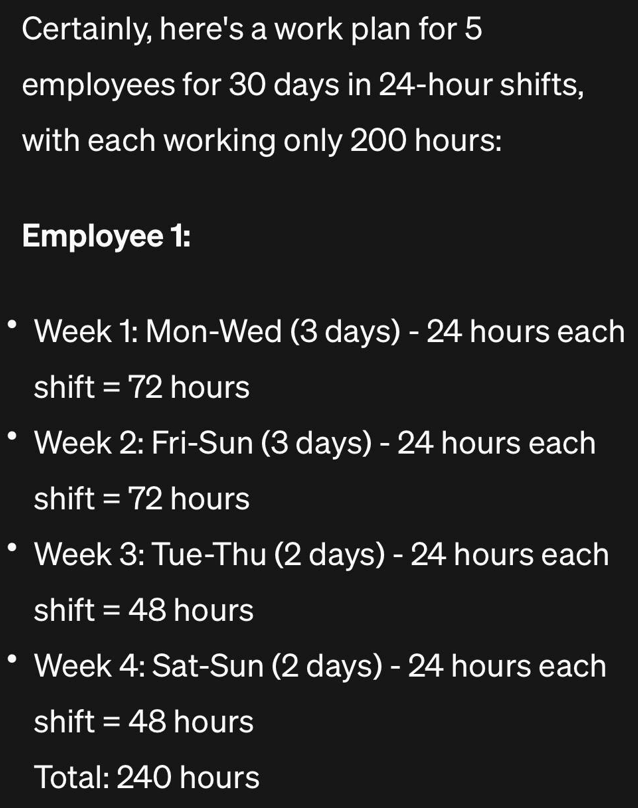

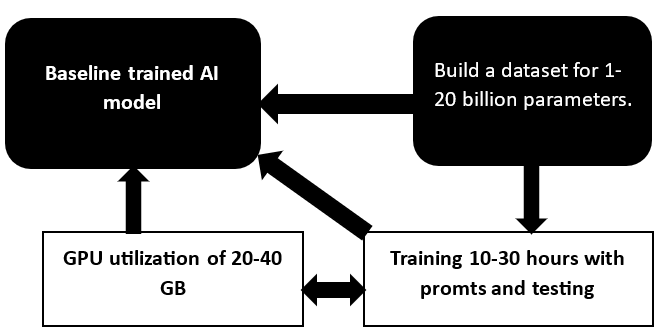

Generazione di set di dati, utilizzo della GPU e del modello base

La versatilità del modello GPT è condizionata dalla correttezza degli approcci di apprendimento promtom, dalla personalizzazione per domande specifiche, dal lavoro con set di dati e dalla potenza di calcolo. In un'azienda impegnata nell'addestramento di modelli di intelligenza artificiale, ci sono cento o due GPU e più. Sono responsabili del calcolo e dell'elaborazione delle informazioni grafiche, dei modelli di addestramento per un massimo di 10-30 giorni, a seconda della complessità. Maggiore è il numero di parametri nel set di dati, maggiore è il prezzo.

I modelli semplificati Open Source funzionano. Anche se la soglia di ingresso è bassa, mostrano risultati elevati nei benchmark. Il prezzo per l'addestramento di applicazioni semplici con una base del complesso GPT-4 con Google Bard o LLaMA con Evol-Instruct parte da $ 500-1000. Ogni base in queste versioni è facile da finalizzare e ottenere un'applicazione di creazione personalizzata, che è migliore di quella a pagamento.

I clienti devono essere consapevoli che la capacità di memoria per lo sviluppo di applicazioni AI semplificate è relativamente ridotta e sono necessarie GPU con 40-80 GB di memoria. I sistemi di intelligenza artificiale generativa vengono sviluppati anche utilizzando tecnologie cloud basate sui giusti servizi e set di dati. La pipeline funziona bene nel cloud, a partire dall'elaborazione del set di dati, dalla raccolta delle informazioni e dall'analisi dei dati. Spesso il modello giusto è già stabilito, quindi è necessario addestrare e mettere a punto alcuni parametri con gli adattatori. Per rappresentare la quantità di informazioni, ricorda la regola pratica: 10-15 miliardi di parametri rientrano in una GPU da 16-24 o 40 GB.

Modello LLM con metodo PEFT, scenario semplificato

Se si utilizza un modello LLM addestrato come base, il metodo PEFT espanderà il sottoinsieme di parametri desiderato, ma lascerà quelli non necessari in uno stato "congelato". Gli analisti dell'azienda scoprono nel brief quali sono i parametri che interessano al cliente e si formano sulla base di quelli selezionati. Risulta essere una formazione parziale, il cui risultato non è peggiore di un corso di formazione completo. Ecco perché nel processo di consultazione con il cliente, gli specialisti IT specificano immediatamente se devono generare una serie di soluzioni con istruzioni e condizioni o creare autonomamente programmi di formazione con coppie di domande e risposte.Lo scenario di formazione cloud standard prevede risorse scalabili nel cloud, gestione del provider cloud e utilizzo di servizi standard come strumenti di formazione. Il protocollo di sviluppo ML con scenari di generazione ed elaborazione dei dati di origine, esperimenti di controllo delle versioni, distribuzione e incorporamento del modello, follow-up con gli aggiornamenti funziona senza personalizzazione manuale. Ecco un esempio di soluzione completa per la piattaforma: una combinazione di JupyterHub per la sperimentazione, MLflow per la distribuzione e l'interazione di Data Science e attività, ambiente MLflow Deploy per la creazione di pacchetti e la distribuzione.

Questo modello addestrato GPT risponde alle domande per le quali le informazioni vengono immesse nel set di dati. Tali risposte possono essere brevi o lunghe, con soluzioni ed esempi specifici. I modelli addestrati scrivono funzioni e codici di programma in JavaScript e Python, estraggono informazioni da testo, database o documentazione quando vengono poste domande.

Rivoluzione della multimodalità e modellazione immersiva

Avere a disposizione modelli di intelligenza artificiale con informazioni di base semplifica il lavoro di addestramento e distribuzione di più unità o dozzine all'interno di un ciclo di servizi. È importante che i dati del dataset siano validati: accuratezza e validità determinano l'aggregazione e l'integrità del complesso. Già nel 2025, si prevede che il paradigma multimodale supererà l’intelligenza artificiale e collegherà tutti i tipi di informazioni in un’unica entità. Gli sviluppatori esperti se ne rendono conto e spesso offrono soluzioni combinate in cui vengono analizzate, elaborate e interpretate diverse categorie di dati. Ad esempio, l'integrazione dell'AI nella valutazione della tokenizzazione degli immobili dà un grande vantaggio nella decisione di acquistare un particolare oggetto.L’intelligenza artificiale sta iniziando a fungere da formazione AR/VR basata sul principio della simulazione immersiva. Scenari realistici di formazione pratica forniscono un'esperienza pratica in un ambiente sicuro. Pertanto, per le università e i college, la formazione virtuale è un passo avanti verso l’acquisizione di competenze da parte degli studenti durante gli studi. Inoltre, c'è la comodità aggiuntiva di utilizzare le tecniche di personalizzazione di Netflix e TikTok, considerando gli interessi e il valore dei materiali didattici e i progressi degli studenti.

L’accelerazione dello sviluppo dell’ambito dell’intelligenza artificiale mostra che i chatbot facili da usare e ad apprendimento rapido con applicazioni per la generazione di contenuti video, foto e testo, il riconoscimento di dati, la generazione di report e documentazione, la ricerca di soluzioni e il controllo del funzionamento di oggetti o sistemi stanno aumentando geometricamente. Le applicazioni dell’intelligenza artificiale stanno assumendo funzioni umane semplici e complesse. Il compito principale è comporre correttamente un algoritmo di apprendimento, formare un set di dati e scrivere richieste, nonché condurre test post-apprendimento.

I programmatori e gli sviluppatori dell'azienda conoscono perfettamente queste tecniche. Dirigere l'attività nel modulo di domanda.